2. 苏州大学附属第二医院放射治疗科, 苏州 215004;

3. 复旦大学附属中山医院放射治疗科, 上海 200032

2. Department of Radiation Oncology, Second Affiliated Hospital of Soochow University, Suzhou 215004, China;

3. Department of Radiation Oncology, Zhongshan Hospital, Fudan University, Shanghai 200032, China

放疗过程中肿瘤靶区的接受剂量与治疗计划系统的偏差应 < 5%,为此放疗工作人员需定期进行剂量验证[1]。目前临床常用的剂量计有电离室剂量计、半导体剂量计和闪烁剂量计等。其中大部分剂量计无法实现三维剂量测量。为了实现快速、准确的三维剂量分布验证,研究人员提出了基于塑料闪烁体的三维剂量验证系统。

三维剂量验证系统由相机、闪烁体和反射镜组成,相机捕获闪烁体受加速器射线束照射产生的闪烁光,结合一定的重建算法进行三维重建。目前常用的重建算法为迭代法[2-7],其使用系统矩阵建立像素与体素的联系,通过不同的迭代方式求出剂量分布的局部最优解,减小投影数据缺失所造成的影响,抑制一定噪声,但系统矩阵的搭建需要耗费大量资源,准确性受主观影响较大。以上方法仍不能使用正交三视角图像准确的重建不规则射野的剂量分布。

本研究在获得正交三视角的闪烁光图像后,未采用传统的迭代法,而是借助卷积神经网络完成剂量分布图重建,避免了使用难以搭建的系统矩阵,有效节省资源。此外,卷积神经网络能够很好的学习到正交三视角图像的相互联系和深层特征,在投影数据稀少的情况下仍能快速、准确的重建出不规则射野剂量分布, 从而实现瞬时三维剂量重建。

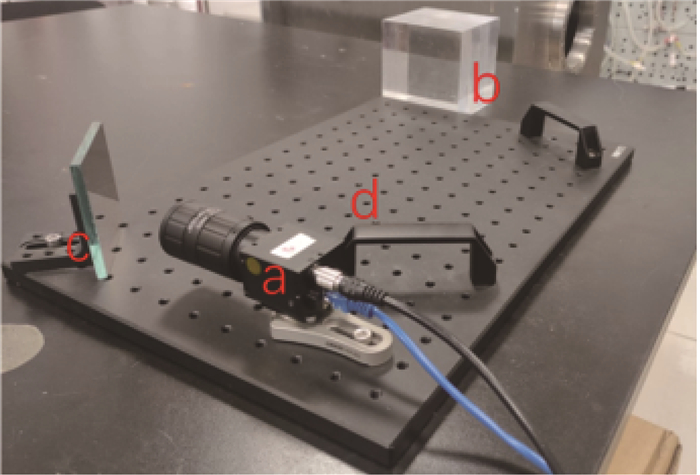

材料与方法1.闪烁光采集系统搭建及临床实验:本研究闪烁光采集系统使用一个互补金属氧化物半导体(complementary metal-oxide-semiconductor, CMOS)相机和一块塑料闪烁体进行搭配,如图 1所示。CMOS相机为迈德威视科技有限公司的MV-GEF1200GM-T型号的工业相机。其成像阵列尺寸为14.13 mm×10.35 mm,分辨率最高可达4 096 × 3 000。选择爱特蒙特光学有限公司(Edmund Optics)型号#59873镜头与相机耦合,镜头固定焦距为50 mm,反射镜为#69252型号反射镜,76.2 mm×76.2 mm,主要作用是防止射线直接入射相机产生噪声和损害。以上设备都固定在光学面包板上。使用相机拍摄参考线及光学标定板确保搭建精准。塑料闪烁体为上海烁杰晶体材料有限公司生产的方形聚苯乙烯基塑料闪烁体,尺寸为10 cm × 10 cm × 10 cm,折射率n=1.58,密度为1.05 g/cm3,发射闪烁光峰值为432 nm。

|

注:a. 互补金属氧化物半导体CMOS相机; b. 闪烁体(此处用PMMA代替); c. 反射镜; d. 光学面包板 图 1 闪烁光采集系统 Figure 1 Scintillation light collection system |

临床闪烁光采集在苏州大学附属第二人民医院放疗科完成。将闪烁光采集系统置于治疗床上,使已标定的闪烁体中心与激光定位系统的十字线重合,确保摆位准确。整体装置使用支架和遮光布以避免外部光线影响。相机曝光时间设为1 s,模拟增益设为1。调整加速器的多叶准直器,获得不同的射野形状。加速器以650 MU/min的剂量率对闪烁体进行照射,单次照射总量为300 MU。相机于加速器出束前开始曝光,加速器出束结束后结束曝光。每次实验前后,使用相机采集暗图像用于图像去噪。为避免多台相机光响应差异的影响,分别将加速器的大机架/小机头旋转角度调整为0°/0°、0°/270°、90°/270°进行实验以实现单相机采集三视角闪烁光图像。辐照5种射野,每种射野重复3次,获得2 cm × 2 cm、3 cm × 3 cm、4 cm × 4 cm的方形射野、凹形射野和凸形射野的正交三视角的荧光图像。

2.虚拟数据集搭建:训练卷积神经网络需要使用大量的闪烁光图像数据。然而,使用医用电子加速器辐照大量不同射野的射线是不经济的,而且整体成像过程也会耗费大量人力和时间。因此,采用光学建模的方式模拟闪烁光三视角图像,并施加伪影以逼近真实图像,从而搭建虚拟闪烁光图像数据集。

首先,使用苏州大学附属第二人民医院放疗科的放疗模拟CT机对塑料闪烁体扫描,获得闪烁体CT影像。利用自编Python代码,调用numpy、pydicom等库,结合闪烁体CT图像进行不同形状的靶区勾画。整体靶区勾画在6 cm × 6 cm的方形范围内。

matRad是一个开源的放疗计划设计软件,由MATLAB编写,使用内部点优化器(interior point optimizer package,IPOPT)进行准确剂量计算[8-9]。将勾画的靶区和闪烁体CT图像输入matRad设计计划,治疗机架、平板床旋转角度均为0°,出束350 MU,得到不同射野的剂量输出。

因塑料闪烁体光产量与能量>125 keV的入射射线在闪烁体内沉积的能量成正比[10],同时在6~20 MeV的能量下,闪烁体发光对射线能量保持独立性,即光产额不受射线能量的影响,所以放疗计划中的剂量分布与闪烁光分布成正比[11-12]。将储存剂量信息的Rtdose文件中的剂量分布在成像视角轴向上切片,并写成16位的IMA文件导入Zemax光学软件。剂量分布体积为10 cm × 10 cm × 10 cm,剂量网格为1 mm × 1 mm × 1 mm,以1 mm × 100 mm × 100 mm作为一个切片,在视角轴向上共得100层切片。在Zemax中对塑料闪烁体建模,在视角轴向上划分为100层,并在每层插入相应剂量切片。根据厂家提供的镜头黑盒文件和相机参数进行光路建模。最后进行光线追踪,视场尺寸为10 cm × 10 cm,模拟图像像素数为1 500 × 1 500,追踪光线数为108。将所有模拟图像加权相加,得到初步模拟图像。

此时模拟图像仍与真实图像有显著的光学伪影差异。根据Robertson等[13]的研究,成像过程中的伪影主要有3个部分,分别是光传播产生的伪影、光学系统产生的伪影和相机传感器产生的伪影。其中界面折射、反射、透视、渐晕和镜头畸变等伪影Zemax都可模拟重现。但因使用切片逐层模拟,其中闪烁光之间的干涉、散射并未反映在模拟中。为使模拟图像更加接近真实图像,使用刃边法得到的点扩散函数对模拟图像进行处理[14-15],模拟光学伪影,随后对图像进行均一化、裁剪,得到中心6 cm × 6 cm的图像,并插值处理,得到最终像素大小为64 × 64的模拟图像。

因维度差异,神经网络很难在二维通量图和三维剂量分布图之间建立联系,所以将二维通量图像做简单视角轴反投影,转化为三维的64 × 64 × 64矩阵。

本研究共随机勾画了93个不同形状的靶区,设计了相应计划,并进行光学模拟、伪影退化、数据增强,得到容量为558的数据集。

3.卷积神经网络模型搭建与训练:U-net因其出色特征提取能力、快速的训练速度以及对小数据集的广泛适用性而大受欢迎[16-17]。本研究选择3D-unet作为神经网络模型,并结合注意力机制、残差结构进行性能优化,即Attention-aware 3D Unet[18-21]。

网络接受64 × 64 × 64的3通道输入图像矩阵,经过编码、解码完成模型训练,输出单通道的64 × 64 × 64图像矩阵。网络通过5次下采样提取特征,使用5次上采样做尺寸扩展、特征融合。

网络整体使用PyTorch进行搭建,数据集容量为558,验证集占比0.2,训练周期为5 000,批量大小为1,采用随机梯度下降,学习率为0.000 1,损失函数为均方误差(mean-square error, MSE)。

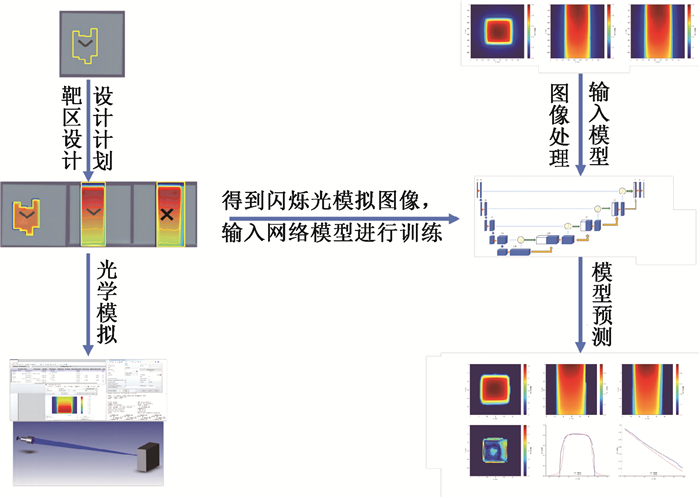

本研究利用三视角闪烁光重建三维剂量的整体流程见图 2。

|

图 2 立体闪烁光三维剂量重建流程图 Figure 2 Flowchart of the three-dimensional dose reconstruction using volumetric scintillation light |

4.图像后处理:图像经卷积神经网络重建后得到初步重建图像。本研究利用射束方向观(beam eyes view, BEV)的闪烁光图像对重建图像进行轮廓切割,得到最终重建图像,并使用伽马通过率[22]、MSE、百分深度剂量曲线(percentage depth dose, PDD)曲线和横向剂量分布曲线(cross beam profile, CBP)曲线对重建图像进行评价。

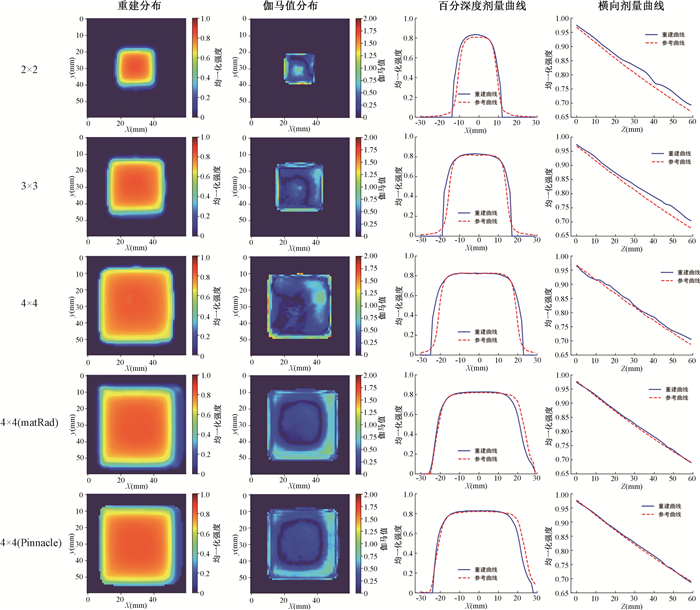

结果分别用matRad和Pinnacle勾画4 cm × 4 cm方形射野,并模拟成像进行三维重建。实际2 cm × 2 cm、3 cm × 3 cm、4 cm × 4 cm射野闪烁光采样在苏州大学附属第二人民医院放疗科完成。2 cm × 2 cm、3 cm × 3 cm、4 cm × 4 cm(真实图像)、4 cm × 4 cm(matRad模拟)、4 cm × 4 cm(Pinnacle模拟)的射野重建图像在z轴中心30 mm处的50%为阈值,3%/3 mm标准的2D伽马通过率分别为94.29%、97.64%、96.03%、100%、96.36%,沿z轴的同标准的平均2D伽马通过率分别为93.38%、95.31%、93.24%、95.48%、96.16%,三维MSE为2.00‰、4.32‰、12.53‰、4.83‰、6.79‰,整体重建较好。所有重建图像x=30、y=30中心处的PDD均方误差维持在1‰以下,y=30、z=30处的CBP均方误差维持在1%以下。在实际图像2 cm × 2 cm、3 cm × 3 cm、4 cm × 4 cm中,以3 cm × 3 cm射野整体为最好。在实际图像4 cm × 4 cm和模拟图像4 cm × 4 cm(matRad模拟)、4 cm × 4 cm(Pinnacle模拟)中,模拟图像重建效果均好于实际图像。方形射野整体重建效果见图 3。所有射野中心层面靶区中心重建较好,伽马通过率>1的部分主要位于靶区边缘半影区,最大值为1.82。CBP曲线在靶区中心拟合良好,主要偏差分布在半影区,半影区平均误差整体占比为56.45%,最大偏差可达39.73%,真实图像重建半影区较大,模拟图像重建半影区较小。PDD曲线整体拟合较好,偏差随深度增加而增加,小射野表现较大射野差,其中2 cm × 2 cm射野PDD最大偏差可达3.19%。

|

图 3 方形射野中心层面的重建结果 Figure 3 Reconstruction results at the center of a square field |

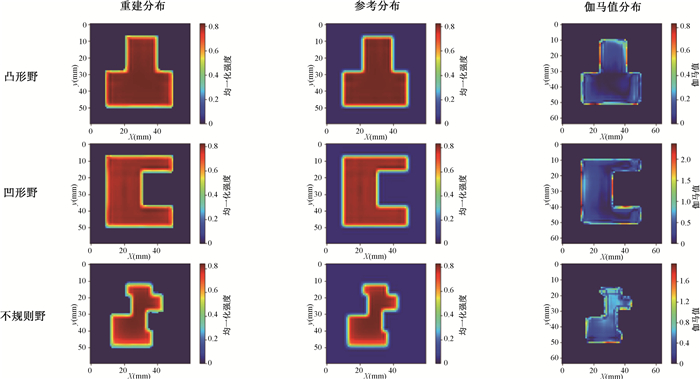

为了满足临床上IMRT复杂射野剂量验证的需要,本研究对该系统重建不规则射野的效果进行了验证。验证的不规则射野有3种,其中凹形、凸形射野的闪烁光图像在苏州大学附属第二医院放疗科采集得到,另一不规则射野闪烁光图像为光学模拟所得。三者重建结果与TPS计算剂量相比,中心层面50%为阈值,3%/3 mm标准的2D伽马通过率分别为92.15%、95.87%、92.98%,所有层面50%为阈值,3%/3 mm标准的平均通过率为91.57%、96.17%、93.02%,三维均方误差在2‰以下。所有重建图像在x=30、y=30中心处的PDD均方误差也维持在1‰以下,PDD曲线拟合良好。3个射野重建结果整体较好,误差分布与方形射野一样,主要分布在射野边缘。重建效果见图 4。

|

图 4 不规则射野中心层面的重建结果 Figure 4 Reconstruction results at the centers of irregular fields |

讨论

目前临床上有许多剂量计,包括但不限于电离室剂量计、热释光剂量计、半导体剂量计、凝胶剂量计、胶片剂量计和闪烁体剂量计。其中电离室剂量计因其能准确的测量单点剂量和平面剂量而被广泛运用。虽然电离室有极高的精度,但其体积容积效应和复杂的电子学读出系统限制了三维剂量测量。基于塑料闪烁体的三维剂量验证系统通过重建闪烁光的分布以重建三维相对剂量分布,弥补了临床上剂量计在三维剂量验证方面的缺失。

基于塑料闪烁体的三维剂量验证系统重点在于将多视角闪烁光图像准确的重建出三维剂量分布。本研究将三视角闪烁光输入已训练好的Attention-aware 3D Unet网络模型,可以快速、准确的重建出三维相对剂量分布,实现实时剂量验证。本研究比较了重建剂量分布与真实剂量分布之间的伽马通过率、MSE等,结果显示模型重建结果与真实剂量分布能较好符合。

传统的ML-EM、OSEM算法需要使用系统矩阵建立目标体素和成像像素之间的联系,而系统矩阵的搭建往往需要耗费一定的时间和人力,且存在一定主观性。使用研究文闪烁光采集系统结合OSEM算法对不同射野的剂量分布进行了重建,其中2 cm × 2 cm、3 cm × 3 cm、4 cm × 4 cm的方形射野重建结果与TPS计算的剂量分布相比,所有层面的3%/3 mm标准的平均伽马通过率为89.12%、89.95%、80.75%,凹形射野的中心层面的3%/3 mm标准的2D伽马通过率为84.1%,均逊于本文重建结果。Rilling等[5-7]使用全光相机结合MLEM算法对复杂凹形射野的剂量分布进行了重建,中心层面重建结果与TPS计算的剂量分布相比,3%/3 mm标准的2D伽马通过率为94.9%。虽然本研究结果与之接近,但其闪烁光采集系统使用的相机是全光相机,能捕获更多深度信息,而本研究使用CMOS相机,有一定信息损失。因此,在设备同性能的情况下,基于卷积神经网络的立体闪烁光重建方法要优于迭代算法,在设备性能有差异的情况下,基于卷积神经网络的立体闪烁光重建方法能弥补设备的性能差异。

本研究重建图像深度方向上以50%为阈值,3%/3 mm标准平均伽马通过率均已达到91%,所有重建图像通过率均值为94.29%,仍有改善空间,主要偏差存在于剂量陡峭区,半影区最大剂量偏差可达39.73%,可见Attention-aware 3D Unet模型对射野边缘的信息提取效果较差。3 cm × 3 cm射野重建效果在方形射野中效果最好,主要原因是搭建虚拟数据集时,随机勾画的靶区大小呈一定正态分布,导致网络对3 cm × 3 cm附近的射野更加敏感。不规则的靶区重建中,凹形射野重建结果较差,原因是数据集中平面凹陷的不规则射野数据偏少,模型未能充分学习此类射野数据。此外,虚拟图像重建结果明显优于真实图像重建的结果,而虚拟图像中又以matRad模拟图像的重建效果最好,逻辑上验证了数据集的有效性,也表明虚拟图像与真实图像仍存在一定伪影差异。因此,在后续研究中,应继续改良网络模型、搭建优良虚拟数据集或真实数据集以提高重建效果。

本研究通过训练卷积神经网络自动学习图像特征,绕过系统矩阵的限制,使用已训练好的网络模型可在数秒内完成剂量分布的重建,实现荧光图像到三维剂量图像之间端到端的映射。与其他使用迭代法重建剂量分布的传统方式相比,本方法重建的剂量精度高,并且能够极大地节省人力、物力与时间成本,为应用闪烁荧光重建放疗三维剂量提供一种新的选择。此外,在不使用全光相机的情况下,卷积神经网络仍能很好弥补视角轴方向上深度信息的缺失,充分提取剂量分布深度方向上的信息,得到准确的PDD曲线,这为闪烁体三维剂量验证系统开辟了更多的硬件选择。

本研究使用在虚拟数据集上训练的卷积神经网络自动提取多视角闪烁光图像的特征信息,并进行特征融合,快速、准确的重建了三维相对剂量分布,完善了闪烁体瞬时三维相对剂量验证系统,为放射治疗质量控制提供了一种新方法。

利益冲突 无

作者贡献声明 董顺成负责实验设计与实施、论文撰写;孙彦泽、杨悦负责实施实验;杜永欢、张佩毅、昂文胜、文万信负责技术指导及论文修改

| [1] |

Shalek RJ. Determination of absorbed dose in a patient irradiated by beams of X or gamma rays in radiotherapy procedures[J]. Med Phys, 1977, 4(5): 461. DOI:10.1118/1.594356 |

| [2] |

Hudson HM, Larkin RS. Accelerated image reconstruction using ordered subsets of projection data[J]. IEEE Trans Med Imaging, 1994, 13(4): 601-609. DOI:10.1109/42.363108 |

| [3] |

Goulet M, Rilling M, Gingras L, et al. Novel, full 3D scintillation dosimetry using a static plenoptic camera[J]. Med Phys, 2014, 41(8): 082101. DOI:10.1118/1.4884036 |

| [4] |

Hui C, Robertson D, Beddar S. 3D reconstruction of scintillation light emission from proton pencil beams using limited viewing angles-a simulation study[J]. Phys Med Biol, 2014, 59(16): 4477-4492. DOI:10.1088/0031-9155/59/16/4477 |

| [5] |

Rilling M, Bourassa F, Archambault L, et al. System matrix generation for 3D tomographic reconstructions using an optical design software [C]. San Diego: SPIE, 2018: 107450. DOI: 10.1117/12.2321677.

|

| [6] |

Rilling M, Archambault L, Thibault S. Simulating imaging-based tomographic systems using optical design software for resolving 3D structures of translucent media[J]. Appl Opt, 2019, 58(22): 5942-5951. DOI:10.1364/AO.58.005942 |

| [7] |

Rilling M, Allain G, Thibault S, et al. Tomographic-based 3D scintillation dosimetry using a three-view plenoptic imaging system[J]. Med Phys, 2020, 47(8): 3636-3646. DOI:10.1002/mp.14213 |

| [8] |

Cisternas E, Mairani A, Ziegenhein P, et al. matRad-a multi-modality open source 3D treatment planning toolkit; proceedings of the World Congress on Medical Physics and Biomedical Engineering [C]. Springer, 2015. DOI: 10.1007/978-3-319-19387-8_391.

|

| [9] |

Wieser HP, Cisternas E, Wahl N, et al. Development of the open-source dose calculation and optimization toolkit matRad[J]. Med Phys, 2017, 44(6): 2556-2568. DOI:10.1002/mp.12251 |

| [10] |

Beaulieu L, Beddar S. Review of plastic and liquid scintillation dosimetry for photon, electron, and proton therapy[J]. Phys Med Biol, 2016, 61(20): R305-R343. DOI:10.1088/0031-9155/61/20/R305 |

| [11] |

Beddar AS, Mackie TR, Attix FH. Water-equivalent plastic scintillation detectors for high-energy beam dosimetry: Ⅰ. Physical characteristics and theoretical consideration[J]. Phys Med Biol, 1992, 37(10): 1883-1900. DOI:10.1088/0031-9155/37/10/006 |

| [12] |

Beddar AS, Mackie TR, Attix FH. Water-equivalent plastic scintillation detectors for high-energy beam dosimetry: Ⅱ. Properties and measurements[J]. Phys Med Biol, 1992, 37(10): 1901-1913. DOI:10.1088/0031-9155/37/10/007 |

| [13] |

Robertson D, Hui CK, Archambault L, et al. Optical artefact characterization and correction in volumetric scintillation dosimetry[J]. Phys Med Biol, 2014, 59(1): 23-42. DOI:10.1088/0031-9155/59/1/23 |

| [14] |

李铁成, 陶小平, 冯华君, 等. 基于倾斜刃边法的调制传递函数计算及图像复原[J]. 光学学报, 2010, 30(10): 2891-2897. Li TC, Tao XP, Feng HJ, et al. Modulation transfer function calculation and image restoration based on slanted-edge method[J]. Acta Optica Sinica, 2010, 30(10): 2891-2897. DOI:10.3788/AOS20103010.2891 |

| [15] |

闫学文, 李华, 何良, 等. 放疗3D剂量验证系统中光场相机点扩散函数获取[J]. 应用光学, 2021, 42(1): 43-48. Yan XW, Li H, He L, et al. Point spread function acquisition of light field camera in 3D dose verification system for radiotherapy[J]. J Appl Optic, 2021, 42(1): 43-48. DOI:10.5768/JAO202142.0101007 |

| [16] |

Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation; proceedings of the Medical Image Computing and Computer-Assisted Intervention–MICCAI 2015[C]. Athens: Springer, 2015. DOI: 10.1007/978-3-319-24574-4_28.

|

| [17] |

殷晓航, 王永才, 李德英. 基于U-Net结构改进的医学影像分割技术综述[J]. 软件学报, 2021, 32(2): 519-550. Yin XH, Wang YC, Li DY. Suvery of medical image segmentation technology based on U-Net structure improvement[J]. J Soft, 2021, 32(2): 519-550. DOI:10.13328/j.cnki.jos.006104 |

| [18] |

Çiçek Ö, Abdulkadir A, Lienkamp SS, et al. 3D U-Net: learning dense volumetric segmentation from sparse annotation; proceedings of the Medical Image Computing and Computer-Assisted Intervention–MICCAI 2016[C]. Athens: Springer, 2016. DOI: 10.1007/978-3-319-46723-8_49.

|

| [19] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition; proceedings of the Proceedings of the IEEE conference on computer vision and pattern recognition [C]. Athens: Springer, 2016. DOI: 10.1109/CVPR.2016.90.

|

| [20] |

Oktay O, Schlemper J, Folgoc LL, et al. Attention u-net: Learning where to look for the pancreas[J]. arXiv preprint arXiv: 180403999, 2018. DOI:10.48550/arXiv.1804.03999 |

| [21] |

Osman AF, Tamam NM. Attention-aware 3D U-Net convolutional neural network for knowledge-based planning 3D dose distribution prediction of head-and-neck cancer[J]. J Appl Clin Med Phys, 2022, 23(7): e13630. DOI:10.1002/acm2.13630 |

| [22] |

Low DA, Harms WB, Mutic S, et al. A technique for the quantitative evaluation of dose distributions[J]. Med Phys, 1998, 25(5): 656-661. DOI:10.1118/1.598248 |

2023, Vol. 43

2023, Vol. 43